Thinking in Zahlen

Gesamtparameter

1T

Mixture‑of‑Experts‑Architektur

Aktive Parameter

32B

Effiziente Berechnung pro Token

Kontextfenster

256K

Ganze Research‑Papers verarbeiten

HLE‑Score

51.0

Heavy‑Mode‑Reasoning‑Genauigkeit

Was Thinking anders macht

Kimi K2 Thinking generiert nicht nur Antworten – es argumentiert Schritt für Schritt und zeigt seine Herleitung wie ein menschlicher Experte

Schritt‑für‑Schritt‑Reasoning

Beobachten Sie, wie das Modell komplexe Probleme in logische Schritte zerlegt. Kimi K2 Thinking zeigt seinen Denkprozess, wodurch Antworten transparent und überprüfbar werden – ideal für Bildung und kritische Anwendungen.

Erweiterte Tool‑Orchestrierung

Führen Sie 200–300 sequentielle Tool‑Calls ohne Qualitätsverlust aus. Ob API‑Ketten, Datenpipelines oder die Koordination mehrerer Systeme – Thinking Mode erledigt das präzise.

Native INT4‑Quantisierung

2x Speed‑up durch INT4‑Weight‑only‑Quantisierung für MoE‑Komponenten. Quantization‑Aware Training (QAT) nach dem Training sorgt für keinen Genauigkeitsverlust – alle Benchmarks nutzen INT4‑Präzision.

Für Forscher und Ingenieure gebaut

Von akademischer Forschung bis Production‑Systemen: Thinking Mode liefert dort, wo Präzision zählt

Mathematisches Reasoning

Löst Wettbewerbs‑Mathematik mit 100% Genauigkeit auf AIME25‑Aufgaben. Von abstrakter Algebra bis zu Analysis liefert Thinking Mode strenge Beweise und klare Erklärungen.

Research‑Analyse

Verarbeitet wissenschaftliche Papers, synthetisiert Erkenntnisse und identifiziert Muster über hunderte Quellen. Das 256K‑Kontextfenster umfasst ganze Literaturreviews in einer Sitzung.

Frontend‑Entwicklung

Deutliche Verbesserungen bei HTML, React und komponentenintensiven Aufgaben – verwandeln Sie Ideen in funktionale, responsive Produkte. Bauen Sie komplexe UIs aus einem Prompt mit hoher Präzision.

Agentische Suchaufgaben

Score 60.2 auf BrowseComp – der höchste unter offenen Modellen. Thinking Mode navigiert autonom durch Informationsräume, prüft Quellen und synthetisiert Insights.

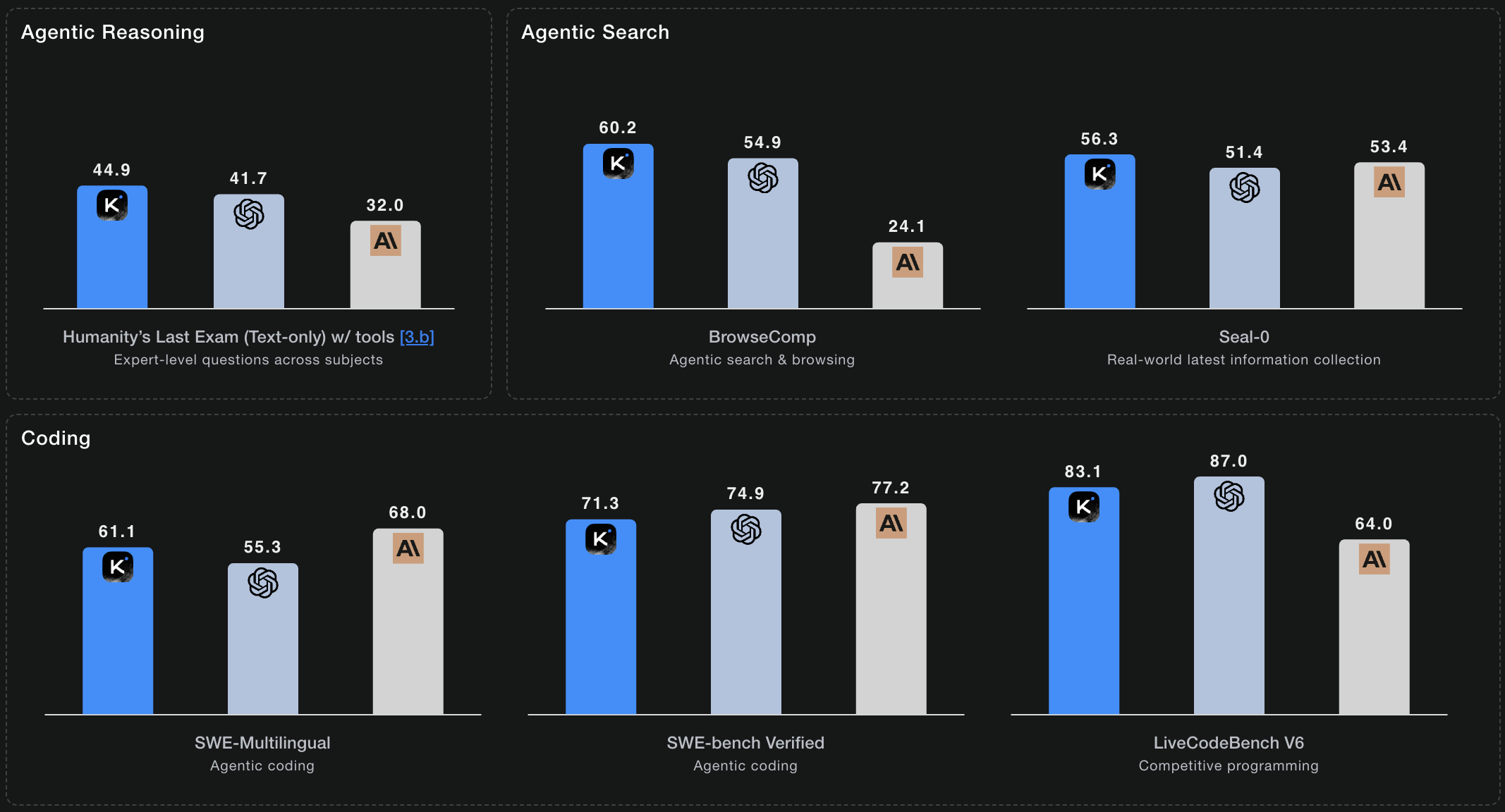

Benchmark‑Performance

Kimi K2 Thinking erzielt State‑of‑the‑Art‑Ergebnisse bei reasoning‑fokussierten Evaluierungen

HLE: 51.0 (Heavy)

Humanity's Last Exam umfasst Expertenfragen über 100+ Fächer. K2 Thinking erreicht 44.9% mit Tools und 51.0% im Heavy‑Mode – mit parallelen Reasoning‑Trajektorien für anspruchsvollste Probleme.

AIME25: 100.0

American Invitational Mathematics Examination. 100% Genauigkeit mit Python‑Tools bei Wettbewerbs‑Mathematik, die selbst Experten fordert.

BrowseComp: 60.2

Agentische Websuche und Informationssynthese. 60.2 Punkte – bestes Ergebnis unter Open‑Source‑Modellen – zeigt starke autonome Research‑Fähigkeiten.

SWE-Bench Verified: 71.3%

Reale Software‑Engineering‑Aufgaben aus GitHub‑Issues. 71.3% Genauigkeit auf verifizierten Problemen – produktionsreife Coding‑Fähigkeiten über Branchenbenchmarks.

Technische Features

Was Entwickler und Forscher wissen müssen

Mixture‑of‑Experts‑Architektur

384 spezialisierte Experten, 8 pro Token ausgewählt. Das liefert Trillion‑Parameter‑Intelligenz, während nur 32B Parameter pro Inferenz aktiv sind – optimales Verhältnis von Fähigkeit und Effizienz.

Multi-head Latent Attention (MLA)

Fortgeschrittener Attention‑Mechanismus, der die Kohärenz des Reasonings über lange Kontexte verbessert. MLA ermöglicht ein besseres Verständnis komplexer Beziehungen in großen Dokumenten.

OpenAI‑ & Anthropic‑kompatibel

Drop‑in‑Replacement für bestehende Integrationen. Gleiche API‑Formate, gleiche Parameter – verweisen Sie Ihren Code auf Kimi K2‑Endpoints und sehen Sie bessere Performance.

Mehrere Inference‑Engines

Bereitstellung mit vLLM, SGLang oder KTransformers. Wählen Sie den Engine‑Stack für Ihre Infrastruktur – alle sind für Kimi K2 Thinking optimiert.

Open Source unter MIT‑Lizenz

Vollständige Modellgewichte für Forschung und kommerzielle Nutzung. Die Modified‑MIT‑Lizenz erlaubt den Einsatz überall – von Startups bis Enterprises.

Production‑ready API‑Zugriff

Verfügbar auf kimi-k2.ai mit transparenten Preisen und Enterprise‑Zuverlässigkeit. Drop‑in‑kompatibel zu OpenAI/Anthropic – URL ändern und Kimi K2 Thinking nutzen.

Performance‑Highlights

K2 Thinking liefert State‑of‑the‑Art‑Performance bei Reasoning, Coding und agentischen Aufgaben

* Benchmarks aus der offiziellen Kimi K2 Thinking‑Dokumentation

Häufige Fragen

Alles, was Sie über Kimi K2 Thinking wissen müssen

Worin unterscheidet sich Thinking Mode vom Standard‑Kimi K2?

Thinking Mode ist auf mehrstufiges Reasoning spezialisiert und zeigt seine Herleitung. Standard‑Kimi K2 ist stark bei allgemeinen Aufgaben, Thinking Mode ist optimiert für tiefe logische Analyse – mathematische Beweise, Research‑Synthesen, komplexes Debugging. Es ist der Unterschied zwischen schneller Antwort und ausführlicher Lösung mit Beweis.

Wie hoch sind die Kosten für Thinking Mode?

Wir bieten transparente, wettbewerbsfähige Preise auf kimi-k2.ai. Starten Sie mit kostenlosen Credits, dann wählen Sie flexible Pay‑as‑you‑go‑ oder Abo‑Pläne. Self‑Hosting ist ebenfalls möglich: Open‑Source‑Gewichte unter Modified‑MIT‑Lizenz.

Kann ich Thinking Mode auf eigenen Servern betreiben?

Ja. Vollständige Modellgewichte sind unter der Modified‑MIT‑Lizenz verfügbar. Deploy mit vLLM, SGLang oder KTransformers auf eigener Infrastruktur. Die Hardware‑Anforderungen hängen von Ihrem Durchsatz und der INT4‑Quantisierung ab.

Wie funktioniert die Tool‑Orchestrierung?

Thinking Mode kann 200–300 sequentielle Tool‑Calls aneinanderreihen — API‑Requests, Datenbank‑Queries, Datei‑Operationen — ohne Kontextverlust. Es plant den Workflow, behandelt Fehler robust und passt sich an Zwischenergebnisse an.

Wie ist die reale Performance bei Coding‑Aufgaben?

Kimi K2 Thinking erreicht 100% Genauigkeit auf AIME25‑Matheaufgaben bei Nutzung von Python‑Tools. Der Schritt‑für‑Schritt‑Ansatz ist besonders effektiv für komplexe Code‑Muster, Edge Cases und robuste Implementierungen.

Ist Thinking Mode für Production geeignet?

Absolut. Mit nativer INT4‑Quantisierung (2x Speed‑up) und enterprise‑grader Infrastruktur auf kimi-k2.ai ist es vom ersten Tag an produktionsreif. Nutzen Sie unsere gehostete API mit OpenAI/Anthropic‑Kompatibilität oder deployen Sie die Open‑Source‑Weights selbst.

Bereit, tiefer zu denken?

Erleben Sie die nächste Generation von Reasoning‑AI. Starten Sie noch heute mit Kimi K2 Thinking.